Dans les années à venir, une nouvelle informatique, fondée sur les propriétés bizarres des particules quantiques, capables d’être dans deux endroits à la fois ou de s’influencer à distance, va révolutionner le monde du calcul, du traitement de l’information, des télécoms, de la modélisation, de la médecine et de la biologie. Explications en cinq épisodes.

29 juillet 2016 à 18h40

UneUne révolution technologique est en marche. Appelée « révolution quantique » car elle repose sur la théorie physique des quanta, elle mobilise tous les grands pays industriels et les multinationales de la high-tech, de Google à Microsoft en passant par IBM, Intel ou Hitachi. Dans un avenir proche, elle va bouleverser le calcul, le traitement de l’information, les télécommunications, la métrologie. Et ses applications vont transformer la médecine, la biologie, la science des matériaux et la modélisation.

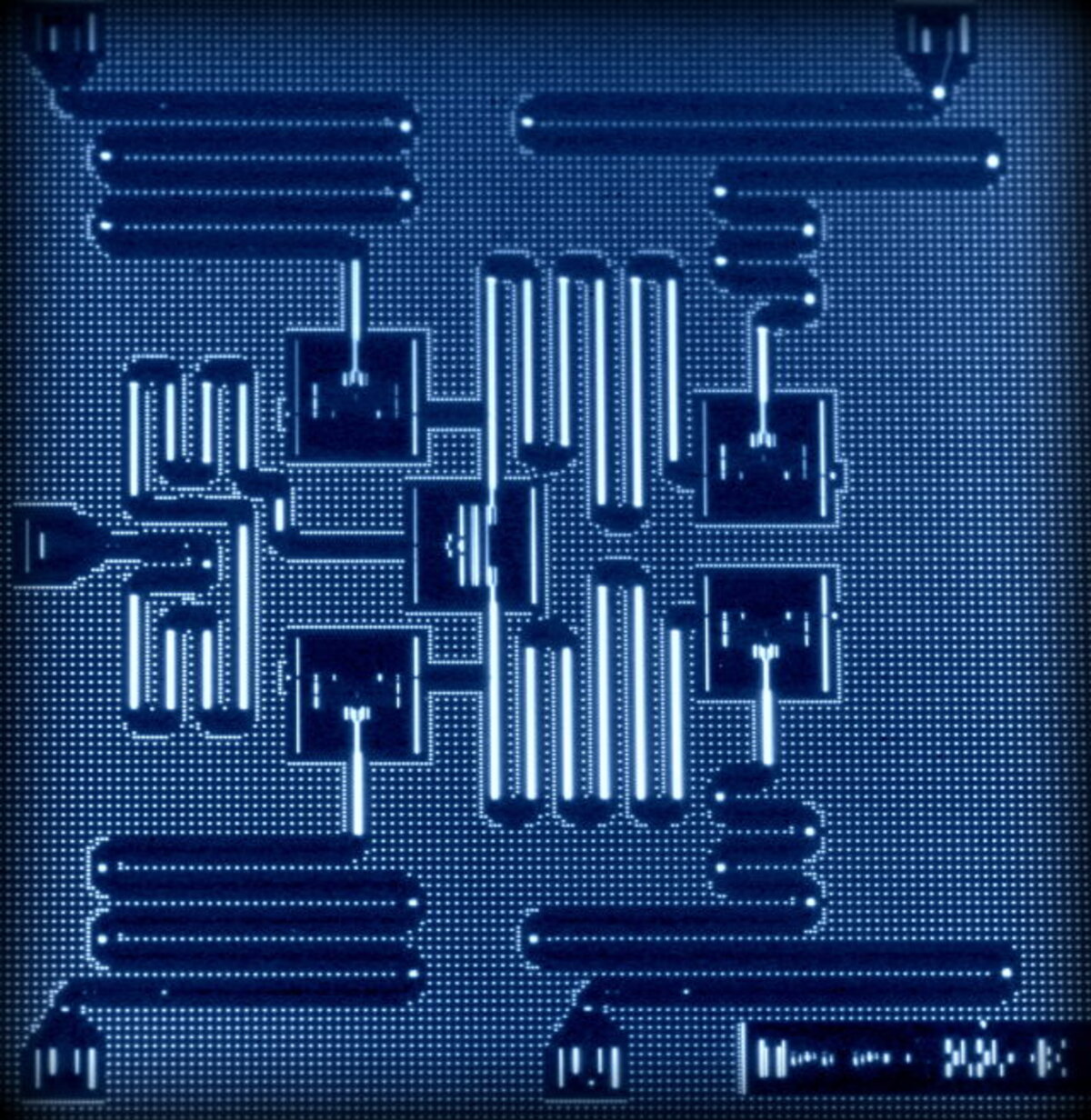

Les 5 qubits de l’ordinateur quantique d’IBM © DR

En mai dernier, un programme d’intelligence artificielle créé par Google, AlphaGo, a stupéfait le monde en battant l’un des plus grands champions de go actuels, Lee Sedol (voir notre article). Mais d’ici cinq à dix ans, cet exploit sera ridiculisé par les prouesses des ordinateurs quantiques, qui résoudront en quelques instants des problèmes dont le traitement demanderait aujourd’hui un temps de calcul supérieur à la durée de vie de l’Univers. Les nouvelles machines pourraient permettre, par exemple, de simuler très précisément des réactions chimiques pour analyser des phénomènes biologiques ou développer de nouveaux médicaments.

Les spécialistes pensent que la technologie quantique pourrait faire accomplir un bond fantastique à l’intelligence artificielle. Google s’est associé à la Nasa pour lancer le Quantum Artificial Intelligence Laboratory (Quail), laboratoire d’intelligence artificielle qui exploite un ordinateur quantique dont les promoteurs affirment qu’il est 100 millions de fois plus rapide que n’importe quelle machine actuelle. La Nasa espère traiter avec ce nouvel outil des problèmes trop complexes pour les calculateurs actuels, comme l’optimisation des trajectoires de vol dans les missions interstellaires.

De son côté, l’Union européenne a lancé en mai le « Quantum manifesto », feuille de route pour le développement de toutes les technologies quantiques et de nouveaux paradigmes en apprentissage automatique et en intelligence artificielle. Le manifeste quantique est associé à une initiative phare dotée d’un financement d’un milliard d’euros pour les années à venir.

Les applications de l’ingénierie quantique ne se limitent pas à l’informatique. Grâce à la « téléportation quantique », il sera possible de transmettre des données instantanément, sans aucun risque d’interception ou de piratage, sur un Internet d’un type nouveau. Des capteurs d’une sensibilité inégalée mesureront les cavités du sous-sol ou détecteront des dépôts minéraux. Des horloges atomiques extrêmement stables synchroniseront des réseaux intelligents de transport d’électricité ou de télécommunications. Etc.

Mediapart consacre une série de cinq articles à la révolution quantique. L’objet de ce premier volet est d’expliquer pourquoi les propriétés très spéciales de particules comme l’électron ou le photon ouvrent la voie à une nouvelle technologie. Le deuxième article présente le principe de fonctionnement des futurs ordinateurs quantiques. Le troisième épisode expose l’impact de la technologie quantique sur l’intelligence artificielle. Le quatrième épisode détaille les applications du « génie quantique » autres que l’ordinateur : télécommunications, Internet, appareils de mesure, etc. Enfin, le cinquième et dernier volet décrit les grandes manœuvres des multinationales telles que Google, IBM ou Microsoft pour tenter de rafler la mise dans cette compétition technologique, et les tentatives de l’Europe pour ne pas se laisser distancer.

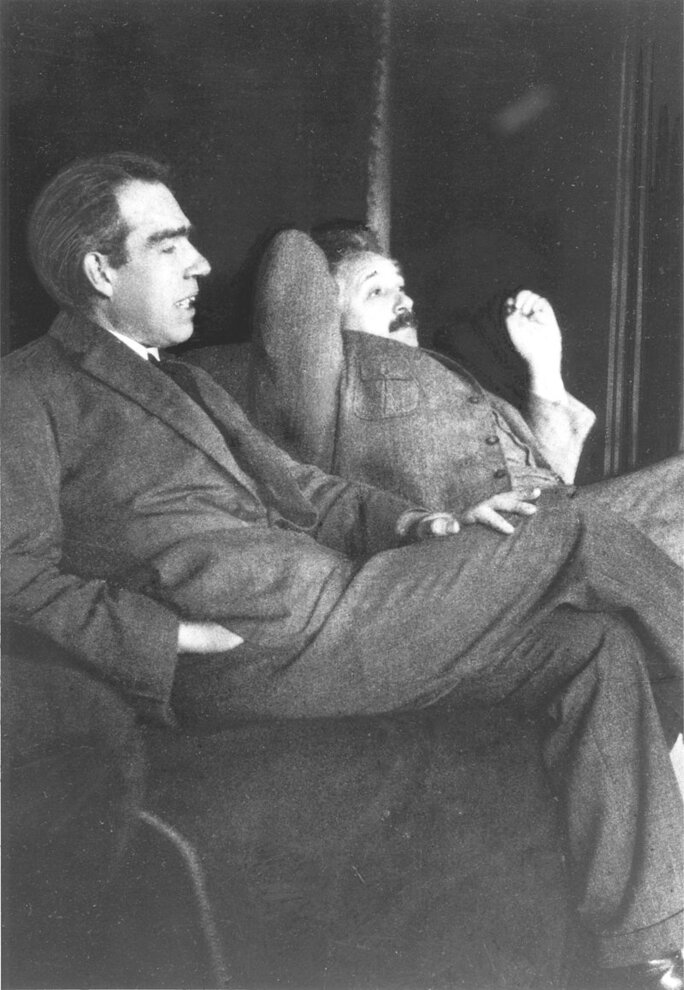

Niels Bohr et Albert Einstein chez le physicien Paul Ehrenfest, à Leyde (Pays-Bas) en 1925 © DR

À première vue, le monde quantique fait moins penser à l’ingénierie qu’à l’univers d’Alice au pays des merveilles, ou aux dessins animés de Tex Avery. Ce monde a commencé à se dévoiler au début du XXe siècle quand des physiciens comme Planck, Einstein, Bohr, Heisenberg ou Schrödinger ont entrepris de décrire la lumière et la matière à l’échelle de l’infiniment petit. Ils ont montré que la nature n’était pas faite de grandeurs continues, que la lumière par exemple était constituée de « grains d’énergie », appelés aujourd’hui photons. Et ils ont découvert qu’au niveau microscopique, l’univers était constitué de particules élémentaires comme l’électron ou le photon, dont le comportement était totalement différent de celui des objets de la physique classique.

Ainsi, une particule quantique peut posséder deux états à la fois, par exemple se trouver en deux endroits en même temps. Cela s’appelle la « superposition d’états ». Elle peut aussi emprunter deux chemins simultanément, comme l’écureuil fou de Tex Avery qui, poursuivi par un chien, se dédouble en deux écureuils identiques fuyant dans deux directions différentes.

À lire aussi Comment Google est devenu maître du jeu de go

9 mars 2016

Des particules « jumelles » peuvent rester associées comme si l’on ne pouvait plus les séparer, quelle que soit la distance entre elles. Imaginez une voiture stationnée sur un parking à Paris et sa jumelle à Marseille. Vous actionnez le volant à Paris, et la voiture tourne à gauche à Marseille. Si l’on n’est pas près de réaliser une telle expérience avec un véhicule, elle a été effectuée de manière reproductible avec des particules jumelles associées, ou « intriquées », selon le terme consacré. Deux particules intriquées restent interdépendantes, aussi éloignées soient-elles l’une de l’autre. Si l’on agit sur l’une, cela entraîne instantanément un effet sur l’autre, comme si elles ne formaient qu’une seule entité.

« La théorie quantique décrit la nature comme absurde du point de vue du sens commun »

Albert Einstein, qui a contribué à fonder la théorie quantique, n’était pas satisfait des effets bizarres prédits par cette théorie. Il parlait avec dédain d’« action surnaturelle à distance » entre les particules intriquées. À ses yeux, une telle action ne correspondait pas à la réalité physique mais à un effet artificiel résultant de l’imperfection de la théorie quantique.

Dans les années 1930, Einstein a engagé un long débat avec son collègue danois Niels Bohr, l’un des pères fondateurs de la théorie quantique. Bohr estimait, contrairement à Einstein, que la théorie quantique était une description correcte de la réalité. Pour Bohr, la réalité physique n’existait pas en elle-même, indépendamment de l’observation : « Il est erroné de penser que l’objet de la physique est de montrer comment la nature est, écrivait le physicien danois. La physique se rapporte à ce que nous pouvons dire à propos de la nature. »

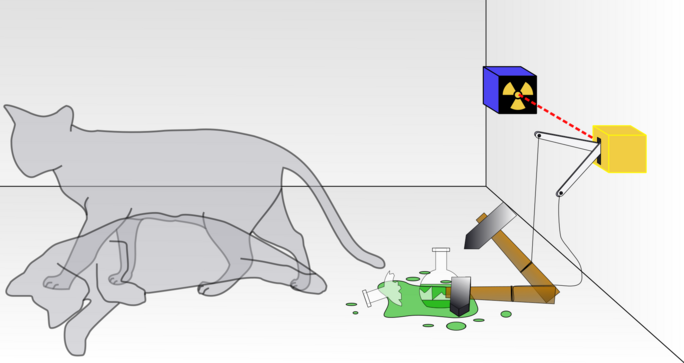

Le chat de Schrödinger: un chat est enfermé dans une boîte de métal avec un flacon de gaz toxique, et un marteau qui peut être déclenché par la désintégration d’un atome radioactif © DR

Einstein ne se satisfaisait pas de cette vision. Il a trouvé un soutien en la personne de l’Autrichien Erwin Schrödinger, autre cofondateur de la théorie quantique. Pour démontrer l’absurdité de la notion d’états superposés, Schrödinger a imaginé en 1935 une expérience de pensée assez cruelle. Un chat est enfermé dans une boîte en acier avec un compteur Geiger, un flacon de gaz mortel, un marteau, et un atome radioactif. Quand l’atome se désintègre, le compteur le détecte et actionne le marteau qui libère le poison, ce qui tue le chat. La désintégration radioactive est un processus aléatoire, et il n’y a aucun moyen de prédire quand elle va se produire.

Vous caressez le chat, vous fermez la boîte et vous allez faire un tour – en espérant que les défenseurs des animaux ne vous ont pas repéré. À votre retour, vous ouvrez la boîte et vous trouvez un chat mort ou vif – ou peut-être agonisant, selon que l’atome s’est désintégré ou non.

Jusqu’ici tout va bien, sauf peut-être pour le chat. Mais voici la question piège : quelle était la situation juste avant que vous n’ouvriez la boîte ? Pour le sens commun, c’est simple : ou l’atome s’est déjà désintégré et le félidé est au paradis des chats, ou il n’y a pas encore eu de désintégration et le chat attend avec impatience d’être libéré.

Pour un physicien quantique, l’affaire est plus complexe. L’atome se trouve dans une superposition d’états, désintégré et non désintégré en même temps. Le destin du chat est entièrement lié à l’événement imprévisible que constitue la désintégration. Tant que vous n’avez pas ouvert la boîte, tout ce que vous pouvez dire, c’est qu’elle contient une superposition d’états chat mort-chat vivant. Situation que Schrödinger qualifie de « ridicule ».

Selon Einstein, le paradoxe du chat de Schrödinger établissait que la théorie quantique était incomplète et ne représentait qu’une étape provisoire. Bohr pensait à l’inverse que la description quantique était suffisante. Ce débat a longtemps été purement conceptuel. Pour la plupart des physiciens, choisir entre la position d’Einstein et celle de Bohr relevait d’un choix philosophique, sans conséquence pratique.

Puis il est apparu, au début des années 1960, que dans certaines situations expérimentales, les résultats observés ne seraient pas les mêmes selon que Bohr ou Einstein avait raison. À partir de 1975, plusieurs expériences ont été menées pour tester les deux interprétations de la théorie quantique.

La principale de ces expériences a été réalisée par le Français Alain Aspect, à l’université d’Orsay. Elle a démontré de manière éclatante qu’Einstein s’était trompé et que Bohr avait raison : la théorie quantique décrit bel et bien le comportement réel des objets comme l’électron ou le photon. Ridicule ou pas, le chat de Schrödinger a toute sa place dans le bestiaire de la physique.

https://cdn.embedly.com/widgets/media.html?src=https%3A%2F%2Fwww.youtube.com%2Fembed%2F1YhUvCnQPVg%3Ffeature%3Doembed&url=http%3A%2F%2Fwww.youtube.com%2Fwatch%3Fv%3D1YhUvCnQPVg&image=https%3A%2F%2Fi.ytimg.com%2Fvi%2F1YhUvCnQPVg%2Fhqdefault.jpg&key=c01725fdc60d4163862c69a3537692ff&type=text%2Fhtml&schema=youtube Conférence d’Alain Aspect sur le débat Bohr-Einstein et la révolution quantique, tenue en 2015 à l’IHES (Institut des hautes études scientifiques) © Institut des Hautes Études Scientifiques (IHÉS)

Le grand physicien américain Richard Feynman a résumé la situation en trois phrases : « La théorie quantique décrit la nature comme absurde du point de vue du sens commun. Et elle est totalement en accord avec l’expérience. Aussi j’espère que vous acceptez la nature telle qu’elle est, absurde. »

Si cette absurdité peut sembler philosophiquement dérangeante, elle offre des avantages pratiques. Le fait qu’une particule puisse posséder deux états à la fois heurte le sens commun, mais cela peut être très utile du point de vue du calcul informatique. Dans un ordinateur classique, une unité d’information (un bit) ne peut prendre qu’une valeur, 0 ou 1, de même que dans le monde ordinaire, une porte est ouverte ou fermée.

La miniaturisation des circuits classiques touche à ses limites

Mais supposez que vous puissiez construire un ordinateur dans lequel le support d’un bit d’information est une particule quantique possédant deux états. Un tel bit quantique, ou « qubit », ne serait pas obligé de posséder une seule valeur ; il pourrait, du fait de la superposition d’états, être à la fois 0 et 1. Ce qui lui permettrait de participer simultanément à deux calculs distincts, l’un dans lequel il aurait la valeur 0 et l’autre dans lequel il aurait la valeur 1.

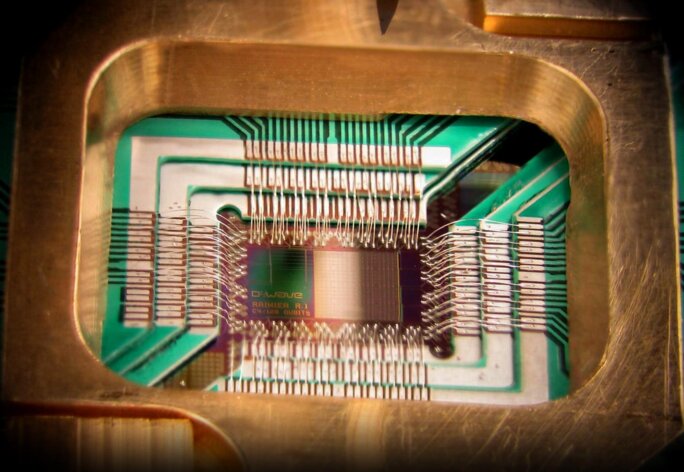

Puce construite par D-Wave systems, utilisant des circuits supraconducteurs © DR

De même, avec deux qubits, on pourrait faire quatre calculs (deux fois deux), on pourrait en réaliser huit avec trois qubits, et ainsi de suite. Du fait de la progression exponentielle, même un nombre relativement limité de qubits permettrait de réaliser un grand nombre d’opérations élémentaires.

« C’est comme ce problème traditionnel de maths scolaires qui consiste à demander à des enfants s’ils préfèrent avoir 1 000 dollars tout de suite ou un cent aujourd’hui, deux cents demain, et ainsi de suite pendant 30 jours, dit Peter Lee, directeur de la recherche chez Microsoft. Beaucoup d’enfants voudront les mille dollars, mais les pennies doublés jour après jour aboutissent à une somme finale de plus de 10 millions de dollars. »

Autrement dit, avec les qubits, la puissance de calcul peut progresser exponentiellement et dépasser de loin celle des ordinateurs classiques – du moins si l’on arrive à concrétiser le concept. Dans les années 1950-60, la révolution de la micro-électronique s’est appuyée sur l’invention du transistor et des circuits intégrés au silicium. En 1965, Gordon Moore, l’un des cofondateurs d’Intel, le premier fabricant mondial de semi-conducteurs, a formulé une « loi » empirique. Selon la première formulation de la loi de Moore, le nombre de transistors sur une puce de silicium double tous les ans. Moore a ensuite ajusté le rythme du doublement à une fois tous les dix-huit mois. L’idée principale étant que la puissance des ordinateurs allait croître de manière exponentielle au cours du temps.

La loi de Moore s’est grosso modo vérifiée jusqu’à aujourd’hui, mais la progression commence désormais à plafonner. Les spécialistes estiment qu’on pourra encore pendant cinq à dix ans continuer à accroître la puissance des ordinateurs constitués de circuits intégrés au silicium, mais qu’on approche de la limite. On ne peut pas indéfiniment miniaturiser les circuits et le recours à des « architectures parallèles », s’il permet de gagner encore en performance, a aussi ses limites.

Cela explique qu’IBM, Intel, Google, Microsoft et d’autres grands de la high-tech s’intéressent aujourd’hui à la physique quantique. Grâce aux qubits, les limites des puces de silicium pourraient être repoussées. Le débat philosophique entre Einstein et Bohr ne s’est clos que pour ouvrir un nouveau champ d’applications technologiques, celles qui reposent sur les propriétés bizarres des objets quantiques.

Il faut noter qu’il y a déjà eu une première révolution quantique. En effet, c’est la théorie quantique qui explique tous les phénomènes à la base des technologies de l’information : elle rend compte de la circulation du courant électrique dans un fil de cuivre, du fonctionnement des semi-conducteurs ou des lasers, de l’effet photo-électrique ou de la supraconduction. En un sens, on peut dire que l’ampoule électrique, le transistor, la télévision, le micro-ordinateur, le lecteur de CD ou le téléphone portable sont des machines quantiques.

Mais ces appareils omniprésents dans notre quotidien ne font pas apparaître les bizarreries quantiques, car ils ne recourent pas à la manipulation d’objets quantiques individuels comme des électrons ou des ions. Dans une ampoule, par exemple, c’est un flux d’électrons qui produit l’échauffement du filament et la lumière. Au contraire, la nouvelle révolution technologique vise à exploiter le comportement étrange d’objets quantiques individuels pour augmenter les performances des ordinateurs et des systèmes de traitement de l’information.

Le tour est loin d’être joué : à ce stade, personne n’a encore trouvé les équivalents quantiques du transistor et de la puce de silicium. Différents dispositifs expérimentaux sont testés par des labos universitaires et des constructeurs, sans qu’aucun d’entre eux ne se soit imposé jusqu’ici.

Dans un ordinateur classique, un bit d’information peut être codé à l’aide d’un interrupteur électronique ouvert ou fermé, laissant ou non passer le courant, l’une des positions correspondant à 0 et l’autre à 1. Un qubit, lui, peut être représenté par n’importe quel système quantique possédant deux états. On peut utiliser par exemple le spin d’un électron. Le spin est une propriété des particules qui, dans le cas de l’électron, ne peut prendre que deux valeurs.

On peut aussi se servir d’un ion possédant deux modes de vibration. Ou d’un circuit supraconducteur en boucle, dans lequel le courant peut circuler dans un sens ou dans l’autre (un supraconducteur est un matériau dans lequel le courant électrique circule sans rencontrer de résistance et sans chauffer ; il fonctionne généralement à très basse température).

Dans ces trois systèmes, pour obtenir un qubit, on associera 0 à un état et 1 à l’autre. Mais à la différence de ce qui se passe dans un circuit électronique ordinaire, un système quantique comme le spin de l’électron peut se trouver dans les deux états en même temps. De sorte que le qubit peut avoir les deux valeurs 0 et 1 en même temps, contrairement à un bit classique qui est forcément égal soit à 0, soit à 1.

IBM a réalisé un ordinateur quantique élémentaire, possédant 5 qubits codés par autant de boucles supraconductrices (il s’agit de circuits supraconducteurs particuliers appelés SQUID, pour superconducting quantum interference device). La firme canadienne D-Wave Systems, qui travaille avec Google, a elle aussi construit un ordinateur quantique utilisant des circuits supraconducteurs.

« C’est facile d’être optimiste quand on ne sait rien »

Sur le papier, ces systèmes peuvent permettre de réaliser un ordinateur quantique de grande puissance. Mais il y a un hic : les qubits sont très délicats à manier. Un petit saut de température, une surtension électrique, une onde cosmique égarée, un choc infime et hop ! la magie quantique s’évanouit. À la moindre interférence, les qubits « décohèrent », perdent leur état quantique, de sorte que tout le calcul est perdu. L’information quantique est aussi fragile que les reflets irisés d’une bulle de savon, qui disparaissent instantanément si la bulle crève.

Pour éviter la « décohérence », il faut protéger les qubits, ce qui est à peu près aussi simple que de maintenir en vie toute une bande de chats de Schrödinger. Pas évident. Il faut autant que possible mettre le fragile système quantique à l’abri des perturbations. « Mais si vous isolez complètement un processeur quantique, il ne peut plus calculer puisque vous ne pouvez plus échanger de signaux avec lui, explique Dario Gil, responsable scientifique chez IBM. Cet équilibre délicat est la raison pour laquelle nous devons refroidir nos qubits supraconducteurs à des températures de l’ordre de quelques millièmes de degrés au-dessus du zéro absolu, technique que nous maîtrisons. »

Microsoft a choisi une approche en quelque sorte inverse : plutôt que de protéger des qubits très fragiles, et de tester des ordinateurs quantiques rudimentaires, se concentrer sur la recherche de qubits plus résistants. « Nous n’essayons pas de construire un ordinateur quantique, explique Peter Lee. Nous croyons qu’essayer de construire une machine quantique en contrôlant des spins d’électrons […], c’est comme essayer de construire un ordinateur en utilisant des tubes à vide [au lieu de transistors et de circuits intégrés]. Nous avons choisi une approche excessivement difficile, et si nous réussissons – c’est un grand “si” – nous aurons un composant de base pour construire une machine extensible. »

Ce composant, destiné à devenir l’équivalent de la puce de silicium pour l’ordinateur quantique, doit avoir des propriétés physiques exceptionnelles. Microsoft cherche à mettre au point un qubit plus stable que ceux qu’utilisent ses concurrents. Pour le dénicher, la firme a entrepris une recherche de très haut niveau en physique fondamentale, travaillant sur des systèmes quantiques qui apparaissent quand des électrons sont piégés à l’intérieur de certains matériaux. De tels systèmes sont insensibles aux perturbations qui déstabilisent les qubits « ordinaires ». À une température proche du zéro absolu, les électrons piégés acquièrent des propriétés étranges. Ils forment ce que l’on appelle un liquide d’électrons. Les propriétés collectives d’un tel liquide peuvent être utilisées pour représenter un qubit.

Mais pour que cela fonctionne, il faut pouvoir manipuler des particules hypothétiques dont l’existence a été postulée en 1937 par un jeune physicien italien, Ettore Majorana. Une particule de Majorana possède une propriété très étonnante : elle est sa propre antiparticule, et peut en somme s’annihiler elle-même.

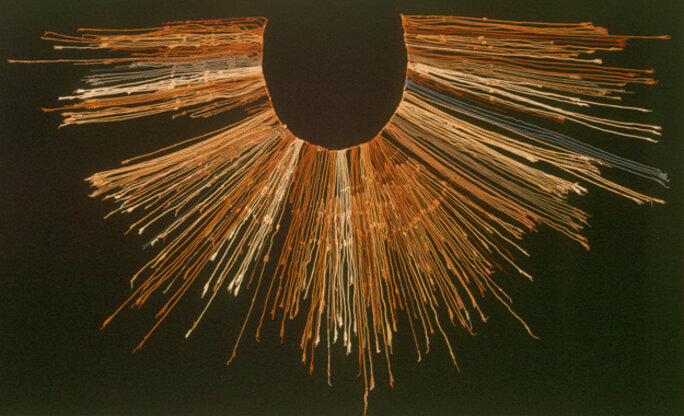

Exemple de quipu de l’empire Inca, Larco Museum Collection © DR

Majorana a prédit l’existence de cette particule sur la base de spéculations très théoriques que l’on n’avait, à l’époque, aucun moyen de vérifier expérimentalement. Le physicien italien a lui-même disparu mystérieusement l’année suivante, à peine âgé de 32 ans, au cours d’un voyage en Sicile – c’est du moins ce que l’on suppose –, sans que l’on sache s’il s’est suicidé à la suite d’une dépression ou s’il a été enlevé en Russie. Ni si sa particule existait vraiment.

Cette licorne du bestiaire quantique n’avait donc jamais été observée jusqu’à ce que Microsoft s’y intéresse sérieusement. Pour la dénicher, la firme de Redmond a fait appel à des physiciens de premier plan, notamment Charles Marcus de l’université de Copenhague, au Danemark, où enseigna Niels Bohr ; et Leo Kouwenhoven de l’université de Delft, Pays-Bas.

Ce dernier a détecté la fameuse particule de Majorana en 2012. Précisons que ce n’est pas une particule au sens classique, mais plutôt ce que les physiciens appellent une « quasi-particule ». Ce n’est pas un objet identifié mais un phénomène collectif, un peu comme une ola dans un stade de football. Mais quoi qu’il en soit, Leo Kouwenhoven a montré que la quasi-particule de Majorana n’était pas seulement une spéculation théorique.

L’étape suivante, encore en cours, est de réaliser un dispositif qui permette de déplacer des quasi-particules de Majorana les unes par rapport aux autres. Charles Marcus compare les qubits fondés sur les particules de Majorana à des quipus, ces systèmes faits de cordelettes que les Incas utilisaient il y a 5000 ans pour archiver des statistiques en utilisant des nœuds représentant des nombres. Si la démarche aboutit, il sera possible de stocker véritablement de l’information dans un système quantique – alors que les dispositifs actuels perdent leur cohérence au bout d’une infime fraction de seconde. C’est typiquement un projet à haut risque avec une forte espérance de gain. « Cela peut échouer complètement, comme cela peut balayer toutes les autres idées », résume Marcus.

Quelle approche va réussir ? Celle d’IBM et de Google, qui cherchent dès maintenant à construire des ordinateurs quantiques avec les composants connus ? Ou celle de Microsoft, qui veut inventer l’équivalent quantique de la puce de silicium ? Il est trop tôt pour le dire. Marcus croit dur comme fer à l’approche sophistiquée de la firme de Redmond. Mais, ajoute-t-il, « c’est facile d’être optimiste quand on ne sait rien ».